Así es Bodyguard, la app que te protege del cyberbullying y contenido tóxico en redes sociales

Bodyguard permite a los usuarios bloquear los comentarios negativos y tóxicos para mantener la tranquilidad en redes sociales.

Para nadie es un secreto que en las redes sociales nunca va a faltar aquel que quiera hacerle daño a otros mediante el cyberbullying.

Cuando un usuario acumula varios miles de seguidores en sus cuentas de las plataformas sociales, lo más habitual es que llegue a estar expuesto a comentarios desagradables, insultos y seguidores tóxicos que se dedican a dejar comentarios negativos en sus publicaciones. Estos tipos de usuarios son conocidos como «trolls«.

Aunque, por desgracia, este tipo de discurso del odio se está haciendo cada vez más habitual en redes sociales, existe una startup francesa llamada Bodyguard, la cual ha creado una aplicación que tiene la capacidad de detectar los comentarios y contenidos maliciosos y así bloquearlos para que no le lleguen al usuario. De esta manera, la app le protege de usuarios tóxicos en las redes sociales.

Esta aplicación lleva varios años funcionando en Francia, enfocándose en un principio al contenido en francés, y ahora se ha lanzado también para el mercado angloparlante.

Bodyguard tiene más de 50.000 usuarios en Francia, y utiliza una tecnología de Inteligencia Artificial, capaz de detectar comentarios negativos y abusivos con una precisión de entre el 90 y el 95%, con solo un 2% de falsos positivos. La app se puede conectar con Twitter, YouTube, Instagram y Twitch, pero por el momento no tiene API para TikTok ni Snapchat.

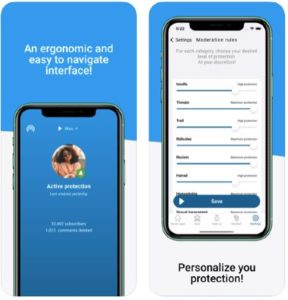

La app posee un mecanismo sencillo: descargas la aplicación, la conectas con las diferentes redes sociales y escoges un nivel de moderación. En este sentido, la aplicación te ofrece varias categorías de moderación tales como: insultos, «body shaming» (avergonzar a los usuarios por su cuerpo), bullying, acoso sexual, racismo y homofobia, y en cada una de estas categorías, tienes la posibilidad de configurar el nivel de moderación entre alto, medio y bajo.

Una vez que ya tengas configurada la moderación, ya no necesitarás volver a acceder a la aplicación, a menos que necesites cambiar alguno de los niveles de moderación. La app funciona en segundo plano, escaneando cada uno de los comentarios y publicaciones de las redes sociales para decidir si ese contenido es tóxico o no. Al detectar esos contenidos negativos, Bodyguard puede bloquear al usuario, silenciarlo o simplemente esconder el comentario. De esta forma, cuando vuelvas a abrir de nuevo la aplicación, verás que no hay nada, como si el contenido negativo ya no existiera.

Al diferencia de otras aplicaciones de moderación de comentarios, Bodyguard no funciona mediante machine learning. En su lugar, utiliza varios algoritmos que realizan el análisis del contenido de un comentario dentro de su contexto, con lo que es capaz de determinar si ese comentario es ofensivo o no.

Con información de Trece Bits