Los índices sobre contenido de odio en Facebook aumentan.

Tras un tormentoso par de años, Facebook decidió ponerle freno al tráfico de las fake news o noticias falsas en su plataforma.

Entre las protestas sociales, el coronavirus COVID-19 y las elecciones en Estados Unidos, el extremismo estuvo a la orden del día y es por ello que la red social de Mark Zuckerberg, tras ser cuestionada por no tomar medidas al respecto desde un principio, tomó la iniciativa y comenzó a implementar medidas de protección. Ahora, la plataforma busca prevenir el extremismo, gracias a la emisión de nuevas advertencias.

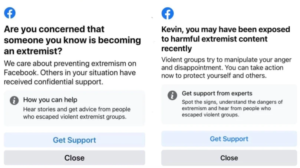

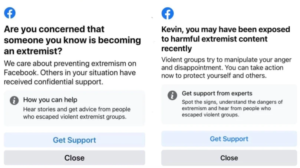

La plataforma le notificará a los usuarios sobre el contenido extremista que se detecte en ella. Incluso, le avisa a las otras personas acerca de las posiciones radicales de sus amigos. En este sentido, existen varias alertas clave:

- ¿Estás consciente de que alguien a quien conoces se está convirtiendo en un extremista?

- Puedes haber estado expuesto a contenido extremista recientemente.

- Grupos violentos tratan de manipular tu ira y decepción. Puedes tomar medidas ahora para protegerte a ti mismo y a los demás.

Estas indicaciones enviadas al usuario lo redirigen a una página de soporte técnico de Facebook. Por los momentos, estas notificaciones se encuentran en período de prueba; pero por lo menos ya hay un norte al que seguir, y todo parece ser cuestión de tiempo para que se ejecute dentro de la red social.

El interés de Facebook para restringir el discurso del extremismo

Andy Stone, portavoz de Facebook, conversó con la cadena CNN con respecto a estas notificaciones ante posts que fomenten el extremismo en la plataforma. “Esta prueba es parte de nuestro trabajo más amplio para evaluar formas de proporcionar recursos y apoyo a las personas en Facebook que pueden haber participado o estado expuestas a contenido extremista, o pueden conocer a alguien que está en riesgo”, señaló Stone.

Además, el portavoz apunta que la compañía le ofrece a los usuarios una variedad de recursos, entre los que se incluye Life After Hate. Se trata de un grupo de defensa que ayuda a las personas a abandonar los movimientos violentos de extrema derecha.

No se habla acerca de otras tendencias del espectro político, al menos de momento. Tampoco se explica cómo trabaja el algoritmo de Facebook para decidir qué posts tienen contenido extremista y cuáles no.

Recientemente, Facebook estuvo en la mira por no tomar las medidas suficientes para restringir el contenido extremista en su plataforma. Entre las críticas, la misma CNN recuerda que en 2020 la red de Mark Zuckerberg no cerró la página de un grupo de milicianos que invitaba a los ciudadanos armados a tomar las calles de Kenosha, Wisconsin.

Durante los hechos del pasado 6 de enero de 2021, cuando partidarios de Donald Trump atacaron el Capitolio para evitar que Joe Biden recibiera la certificación como nuevo presidente de Estados Unidos, se analizó el papel de Facebook como modo de cohesión para los violentos. Posteriormente, la plataforma sancionó al entonces presidente Trump por el impulso que éste le dio a los atacantes.

Aumenta el discurso de odio en las redes sociales

“Esta prueba es parte de nuestro trabajo más amplio para evaluar formas de proporcionar recursos y apoyo a las personas en Facebook que pueden haber participado o estado expuestas a contenido extremista, o pueden conocer a alguien que está en riesgo”, señaló la empresa por medio de un comunicado, citado por CNET.

En febrero, Facebook informó que eliminó una mayor cantidad de contenido fomentando discursos de odio en el cuarto trimestre de 2020. La plataforma sancionó a 26.9 millones de piezas de contenido de odio, en comparación con las 22.1 millones cuentas sancionadas en el tercer trimestre de ese año.

“Nos estamos asociando con organismos no gubernamentales y expertos académicos en este espacio y esperamos tener más para compartir en el futuro”, afirman desde la compañía.

Con información de FayerWayer.